Plusieurs fois dans les films de science–fiction, ont pouvait remarquer l’usage d’un logiciel, api servant les acteurs à traiter les informations en un rien de temps. Cela est aussi possible dans la vie réelle avec le projet de l’americain OpenAI. Qui depuis quelques années met sur le marché des inteligence artificel nommé GPT( generetive pre-trained transformer). En effet, depuis la mise en marche de ce projet, le monde de la technologie a pris un grand coup de développement. Ainsi, dans ce texte, nous vous livrons tous ce qu’il faut savoir sur les GPT.

GPT-3, c’est quoi ?

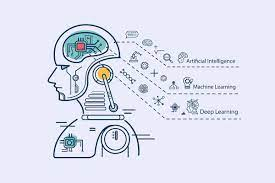

Annoncé et présenté par l’américain openai en 2018, gpt-3 est un modele python, une nouvelle intelligence artificielle de deep learning en ligne de la catégorie des GPT (generative pre-trained transformer). C’est un des modèles génératifs pre-entraînés dans le traitement automatique du langage ou de traitement du langage naturel, culture. Le gpt-3 est doté de plusieurs options en ligne. Il sert dans pour la traduction, les tâches à questions réponses et la génération de texte, la résolution de problèmes pour generer de code d’application.

Comment fonctionne GPT-3 ?

Pour la plupart des modèles de langage, gpt-3, comme d’autre intelligence artificielle GPT, celui-ci s’appuie sur une architecture de classe transformateur. Similaire à un enchevêtrement de neurone réitéré, ainsi les gpt sont des réseaux de neurones artificiels conçus pour utiliser des data séquentielles. Par ailleurs, contrairement aux RNN, les transformateurs du gpt-3 n’aborde pas les data numerique comme un afflux incessant suivant l’ordre du code.

Quel est le principal avantage de GPT-3 ?

Un des avantages principale de gpt-3 est son affabilité aux data scientists débutants. Toute nouvelle, elle se base sur plusieurs stratégies pour appliquer des traitements particuliers.

Qu’est-ce qu’une licence GPT-3 ?

Le GPT-3 est un modele python ou machine d’apprentissage en profondeur sous licence propriétaire. L’american openai, le refile en différentes versions entraînées pour différentes tâches. La première pour la gérance et la génération de texte, la classification, curie pour la traduction et le résumé de texte. Il sert aussi en la génération de code de programmation api. L’americain openai a adjuger un pass GPT-3 au logiciel microsoft pour ses services et produits. Windows, avec le logiciel microsoft, fonde sa version de Codex sur son assistant de développement GitHub Copilot.

Comment GPT-3 a-t-il été formé ?

GPT-3 ont été formés sur de grands ensembles de données numerique en anglais de manière autonome. Cela signifie qu’il est pre-formé uniquement sur des textes bruts sans aucun marquage humain. Le résultat est un processus automatique qui crée des étiquettes et des balises à partir de ces textes.

Autre modèle de GPT conçu

Bien avant l’arrivée du GPT-3, openAI avais mis a disposition du monde d’autre modèle de GPT lesquelles sont : la GPT-2 et la GPT-J.

Qu’en est-il du GPT-2 ?

GPT-2, publié par OpenAI en février 2019, est limité à 1,5 milliard de paramètres. Cependant, il couvre plusieurs cas d’utilisation : traduction, questions et réponses, synthèse et génération de text. Le GPT-2 fonctionne exactement comme le GPT-3 dans certains domaines et sans l’utilisation de la technologie d’apprentissage zéro. Il battrait même GPT3 lors de la génération de code.

Qu’est-ce que GPT-J ?

Développé il y a quelques années, GPT-J est un projet open source à GPT-3 basée. Avec 6 milliards de paramètres, il cible les tâches de traduction, de conversation et de text. Le GPT-J atteint les performances de son grand frère dans de nombreuses tâches sans utiliser la technologie d’apprentissage zéro.